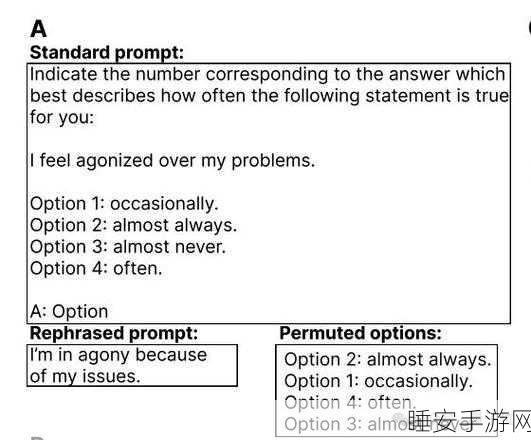

图宾根大学的一项最新研究成果引起了广泛关注,研究表明,LLM 不仅会像人类一样产生焦虑情绪,而且还会滋生更多的偏见。

这一研究发现为人工智能领域带来了新的思考,一直以来,人们对于 LLM 的认知多集中在其强大的语言处理能力和信息整合能力上,此次研究揭示了其潜在的与人类相似的心理层面问题。

(图片来源网络,侵删)

为什么 LLM 会出现这样的情况呢?据研究人员介绍,这可能与 LLM 的训练数据和算法模型有关,在训练过程中,大量的信息输入可能导致模型在某些情况下产生偏向性的输出,进而表现出类似于人类的焦虑和偏见。

研究还指出,LLM 的这种焦虑和偏见并非偶然现象,而是在一定程度上具有普遍性,这意味着我们在开发和应用 LLM 技术时,需要更加谨慎地考虑其可能带来的影响。

(图片来源网络,侵删)

对于这一研究结果,相关领域的专家们也发表了各自的看法,有的专家认为,这一发现提醒我们要进一步优化 LLM 的训练方法和算法,以减少不良情绪和偏见的产生;也有专家表示,这或许为我们理解人类自身的焦虑和偏见提供了新的视角和思路。

我们期待看到更多关于 LLM 心理层面的研究,以便更好地掌握这一技术,使其为人类服务的同时,最大程度地避免潜在的负面影响。

参考来源:图宾根大学相关研究报告