在当今的科技领域,大型语言模型(LLM)的训练备受关注,而其中,准确推算 LLM 训练所需的 GPU 内存量成为了关键环节,这不仅关系到训练的效率和成本,还直接影响着模型的性能和应用效果。

要了解 LLM 训练的 GPU 内存需求,首先得明确 LLM 的规模和复杂性,不同规模和架构的 LLM 对内存的要求差异巨大,大规模的 LLM 通常包含海量的参数,这些参数在训练过程中需要大量的内存来存储和处理。

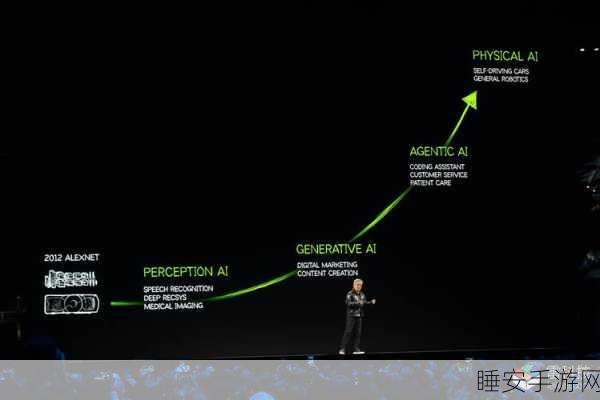

(图片来源网络,侵删)

训练数据的规模和特征也会对 GPU 内存需求产生重要影响,丰富多样且数量庞大的训练数据,需要更多的内存来缓存和处理。

训练算法和优化策略也不能忽视,高效的算法和优化手段能够在一定程度上减少内存的占用,提高内存的利用效率。

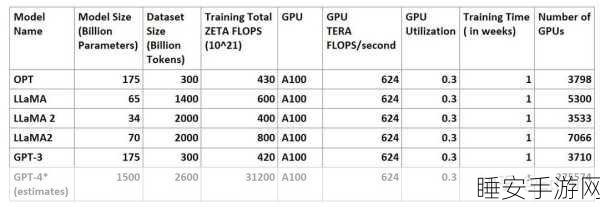

(图片来源网络,侵删)

硬件架构和配置也是决定 GPU 内存需求的因素之一,不同型号的 GPU 具有不同的内存容量和性能特点,需要根据实际情况进行合理选择和配置。

推算 LLM 训练的 GPU 内存需求是一个综合性的问题,需要综合考虑模型规模、训练数据、算法策略以及硬件配置等多个方面,只有全面分析和精准计算,才能为 LLM 训练提供充足且合理的 GPU 内存支持,推动技术的不断发展和应用。

文章参考来源:相关科技研究报告及专业技术文献。